简介

Ollama 是一个开源框架,专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计,通过提供便捷的模型管理、丰富的预建模型库、跨平台支持(提供针对 macOS、Windows、Linux 以及 Docker 的安装指南,确保用户能在多种操作系统环境下顺利部署和使用 Ollama)以及灵活的自定义选项,使得开发者和研究人员能够在本地环境中高效利用大型语言模型进行各种自然语言处理任务,而无需依赖云服务或复杂的基础设施设置。

ollama官网:

ollama github开源代码页:

ollama docker仓库页:https://hub.docker.com/r/ollama/ollama

安装搭建

本次部署依然是在群晖下采用的docker compose部署

其他nas推荐使用dockge或者portainer-ce间接使用docker compose,使用方法请看文章尾部的引用链接

1、ollama docker compose部署(CPU版):

version: "3.3"

services:

ollama:

volumes:

- /volume1/docker/ollama/:/root/.ollama

#用dockge\portainer等部署需对应改成绝对或者相对目录./

ports:

- 11434:11434

container_name: ollama

image: ollama/ollama

environment:

OLLAMA_HOST: 0.0.0.0:11434

OLLAMA_ORIGINS: "*"

#这里0.0.0.0可以允许局域网所有ip连接,端口这里填docker的外网端口号,填写不对会连接不是ollma服务2、ollama docker compose部署(GPU版):

GPU版的我没试,因为我nas没有。。。

部署如果出现问题的同学自己看看官方文档:

NVDIA GPU

version: "3.3"

services:

ollama:

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities:

- gpu

volumes:

- ollama:/root/.ollama

ports:

- 11434:11434

container_name: ollama

image: ollama/ollama

environment:

OLLAMA_HOST: 0.0.0.0:11434

OLLAMA_ORIGINS: "*"AMD GPU

version: "3.3"

services:

ollama:

devices:

- /dev/kfd

- /dev/dri

volumes:

- ollama:/root/.ollama

ports:

- 11434:11434

container_name: ollama

image: ollama/ollama:rocm

environment:

OLLAMA_HOST: 0.0.0.0:11434

OLLAMA_ORIGINS: "*"3、webui部署

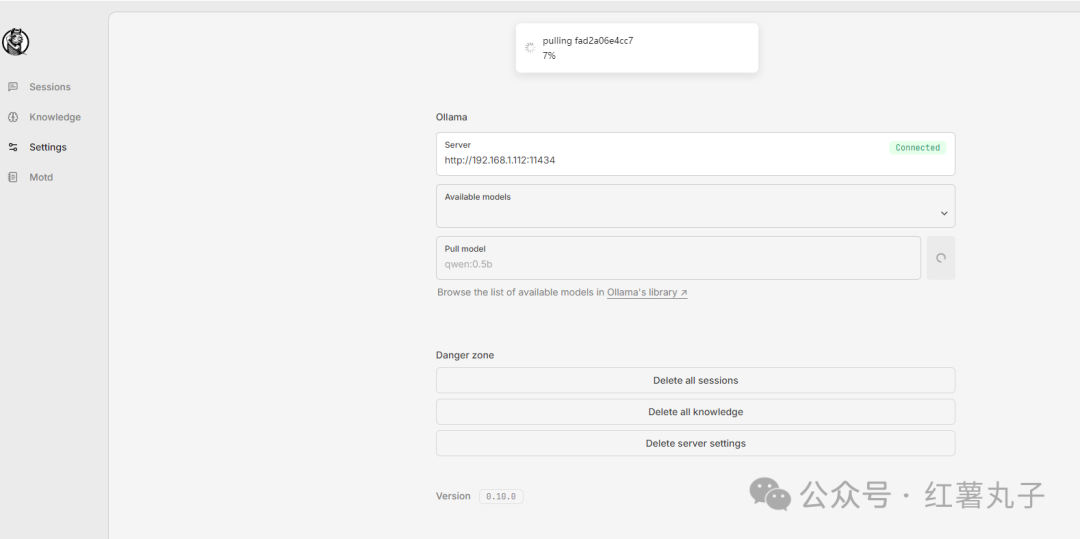

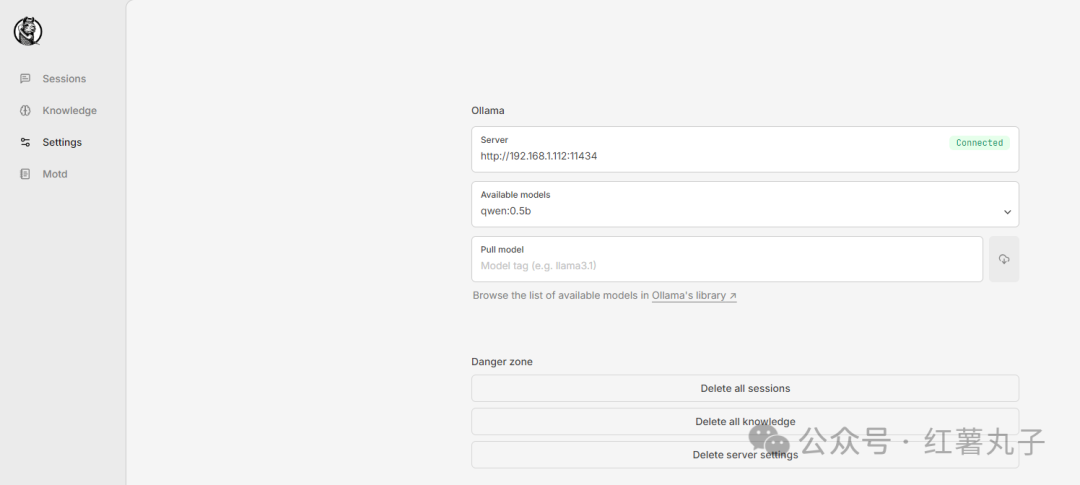

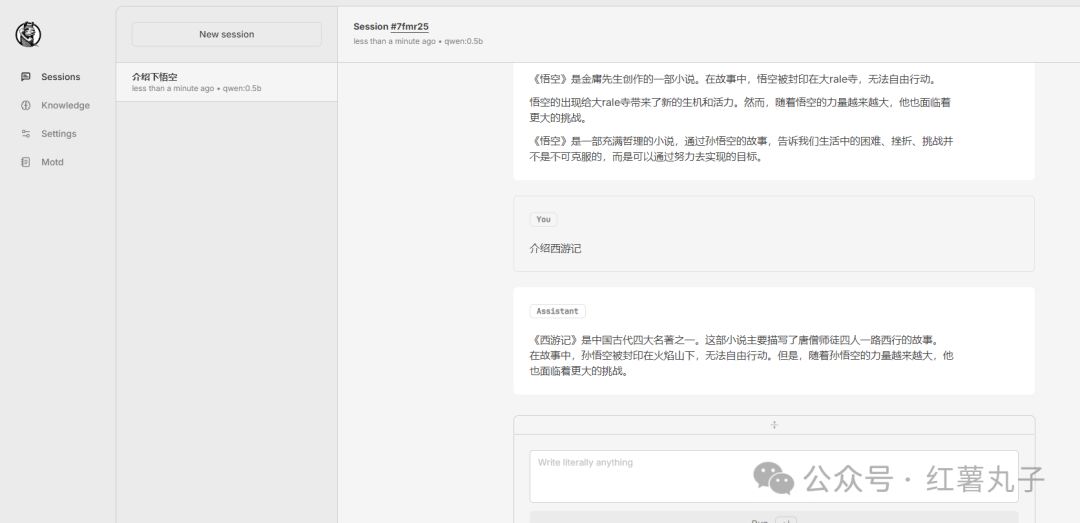

这里我用的是一个极简的webui:hollama,这个webui缺点就是我没找到模型本地映射目录,无中文

因为试了下其他webui,我水平不行,都没跑起来,

openwebui启动我没连外网,一直连不上huggingface,设置了镜像站也没用,有些transformer组件无法下载,麻烦就没弄

dify.ai我注册管理员账号是一直转圈圈,关联容器还一大推,也就没弄了

docker run

docker run --rm -d -p 4173:4173 ghcr.io/fmaclen/hollama:lates

docker compose

version: "3.3"

services:

hollama:

ports:

- 4173:4173

image: ghcr.io/fmaclen/hollama:lates大家按需在settings里面的pull model下载各种开源模型,模型名字在ollama官网有,然后就可以在available models里面自由切换模型进行使用

cpu版的也就只能看看,qwen0.5,300mb的模型问个问题都2-3分钟,还有这低容量的模型答案是真的不行。。。

docker compose部署工具1-dockge:

dockge的部署

红薯丸子,公众号:红薯丸子在nas中部署docker compose可视化管理器dockge

docker compose部署工具2-portainer-ce:

portainer-ce的部署

红薯丸子,公众号:红薯丸子群晖、极空间、威联通、铁威马等nas的docker-compose部署

文章评论